Dinosauri magri, così magri da fare invidia a un felino: è l'inedita immagine che emerge da uno studio pubblicato sulla rivista della Società Zoologica di Londra. I ricercatori infatti hanno ricalcolato il peso di un brontosauro, giungendo alla conclusione che l'animale poteva pesare 18 tonnellate, invece delle 38 che gli erano state attribuite fino a oggi. Una dieta di 20.000 chili non è male, e viene da chiedersi come è possibile che i paleontologi abbiano un tale margine di incertezza. Abbiamo provato a capirlo con Raffaele Sardella, dell'Università di Roma.

Notizie e curiosità in ambito scientifico. Un blog di Fausto Intilla (teorico, aforista, inventore e divulgatore scientifico).

lunedì 27 luglio 2009

Brontosauri e dinosauri si ridimensionano: Audio-Intervista a Raffaele Sardella

Dinosauri magri, così magri da fare invidia a un felino: è l'inedita immagine che emerge da uno studio pubblicato sulla rivista della Società Zoologica di Londra. I ricercatori infatti hanno ricalcolato il peso di un brontosauro, giungendo alla conclusione che l'animale poteva pesare 18 tonnellate, invece delle 38 che gli erano state attribuite fino a oggi. Una dieta di 20.000 chili non è male, e viene da chiedersi come è possibile che i paleontologi abbiano un tale margine di incertezza. Abbiamo provato a capirlo con Raffaele Sardella, dell'Università di Roma.

martedì 21 luglio 2009

Tomografia Neutronica: dove la fisica si fonde con l'archeologia.

Ci sono oggetti antichi che non possono essere maneggiati a piacimento per scoprire qualcosa che li riguarda.

Pensate a delle ampolle, a dei vasi sigillati; il loro contenuto, anche se alterato dai secoli, potrebbe essere analizzato ricavando informazioni preziose. Oppure si pensi alle sculture. Può sembrare strano ma l'interno delle opere scultoree può dare molte indicazioni sulle tecniche usate, sui rifacimenti; nel caso di alcune parti della Porta Est del Battistero di Firenze - un'opera di Lorenzo Ghiberti - ebbero una prima versione che evidentemente conteneva dei difetti e quindi furono rifuse dallo stesso Ghiberti.Anche in questi casi siamo in presenza di dati che non possono certo essere recuperati penetrando in modo invasivo all'interno delle opere d'arte.Tomografia Neutronica: questa è la tecnica dalla quale un progetto europeo che vede impegnati molti paesi, ma che è coordinato da Giuseppe Gorini dell'Università di Milano - Bicocca, si aspetta di ricavare e mettere a punto un nuovo e potente strumento di indagine.

lunedì 20 luglio 2009

Un flash a raggi infrarossi e ultravioletti che consente di scattare foto al buio senza bagliori.

Fonte: Galileo

Fonte: GalileoGrazie alla preventiva rimozione dei filtri che normalmente impediscono di fissare UV e infrarossi, la nuova macchina fotografica è in grado di catturare una prima immagine del soggetto “illuminato”, che risulta nitida ma dai colori alterati. Le foto scattate con questo flash, infatti, ricordano le immagini verdine che si osservano con un binocolo notturno. Per ovviare a questo difetto e ottenere un’immagine fedele ai colori reali, la macchina fotografica scatta un secondo fotogramma immediatamente dopo il primo, senza l’ausilio di nessun flash. Come prevedibile questa seconda immagine sarà scura e offuscata, ma fedele nei colori. A questo punto un sofisticato sowftware saprà combinare le due fotografie ottenendone una terza del tutto realistica.

Nonostante i risultati sorprendenti del prototipo, pubblicati sulla rivista New Scientist, alcuni problemi restano: alcuni oggetti e materiali assorbono gli infrarossi e i raggi UV e quindi non appaiono nelle foto scattate con la tecnica del flash invisibile. Nella foto di un volto, per esempio, le lentiggini scompaiono del tutto. (s.s.)

Riferimenti: New Scientist

Ambienti familiari bilingue: ...un "toccasana" per i bambini.

Mamma russa e papà egiziano, mamma italiana e papà sloveno… Provate a pensare a che confusione può avere in testa un figlio che si trova, ogni giorno, a doversi destreggiare con accenti e idiomi di lingue diverse. Potrebbe verificarsi un ritardo cognitivo? Niente affatto risponde la ricerca scientifica. Un recente articolo apparso sulla prestigiosa rivista Science* ci rivela che il bambino che deve districarsi tra la lingua paterna e quella materna, in realtà, sviluppa un'acutezza e un stato cognitivo superiore ai coetanei monolingui.

L'articolo è firmato da Jacques Mehler, docente di neuroscienzee direttore del Laboratorio “Linguaggio, cognizione e sviluppo” della SISSA di Trieste, ci racconta della scoperta prodotta nei suoi laboratori.

La ricerca:

Ancora prima di iniziare a parlare, un bambino che è esposto a due idiomi fin dalla nascita sa distinguere la lingua materna da quella paterna e riesce ad apprendere regolarità linguistiche più velocemente di un bambino monolingue. Il cervello di un bambino esposto a due lingue, infatti, è più duttile perché è allenato a distinguere gli stimoli verbali della lingua paterna da quelli della lingua materna, senza che le due lingue interferiscano tra loro. Questo non significa che sia più intelligente, ma come un maestro di scacchi è più veloce di un neofita nel memorizzare diverse configurazioni sulla scacchiera, così un bilingue è in grado di acquisire più velocemente e distinguere diverse strutture linguistiche rispetto a un coetaneo monolingue. Perchè è allenato a farlo. E il suo sviluppo cognitivo ne trae vantaggio. Insomma, se un bambino cresce fin dalla culla in un ambiente bilingue apprenderà in maniera naturale due differenti idiomi grazie a una proprietà generale del cervello, la plasticità. E grazie alla ricchezza dell’ambiente linguistico, migliorano alcuni meccanismi di apprendimento. Il bilinguismo infatti è positivo per lo sviluppo cognitivo. Ma ciò non vuol dire che bisogna forzare l’apprendimento di una seconda lingua per rendere tutti i bambini dei bilingui.I neuroscienziati della Sissa hanno realizzato in laboratorio una serie di esperimenti con bambini di 12 mesi - metà bilingui, metà monolingui – impegnandoli in un compito che richiede il controllo delle funzioni esecutive, in modo da poter confrontare la loro performance, e verificare se i bilingui sono effettivamente più bravi nell’apprendere simultaneamente diverse strutture linguistiche.

L’esperimento:

Il vantaggio dei bambini bilingui può essere ricondotto alle abilità di selezionare e monitorare gli stimoli, che li rende capaci di prendere in considerazione solo ciò che ha importanza in un determinato contesto. Come in fondo fanno gli adulti bilingui: devono di volta in volta accendere l’interruttore di una lingua e spegnere l’altra, al fine di parlare quella più appropriata allo scopo. Per chi cresce imparando due lingue, passare da una all'altra è naturale.«I bambini che crescono in una famiglia in cui non si parla una sola lingua, riescono a monitorare più velocemente differenti stimoli linguistici ancora prima di imparare a parlare, e così riescono ad apprendere le proprietà fondamentali della lingua di entrambi i genitori. Così da poter gestire senza difficoltà due idiomi diversi. Infatti anche se un bambino bilingue grosso modo deve imparare il doppio dei vocaboli rispetto a un suo coetaneo monolingue, perché deve apprendere due lingue anziché una, non manifesta alcun ritardo nello sviluppo delle capacità linguistiche. E produrrà le sue prime parole come i bambini monolingui: la prima parola indicativamente intorno a un anno, fino a produrne una quindicina intorno ai diciotto mesi di vita.

Articolo scientifico:

Gli autori:

Agnes Melinda Kovàcs a maggio 2008 ha conseguito il dottorato in neuroscienze cognitive alla Sissa di Trieste e ora continua la sua attività di ricerca al Central European University di Budapest e presso l’Hungarian Academy of Sciences.

L'evoluzione della tecnologia ...dallo spazio al pianeta Terra.

Da bambini tutti abbiamo odiato l'apparecchio per i denti, soprattutto quello di ceramica fatto a placchette attaccate direttamente sul dente. Ecco non immaginerete mai che quella stessa ceramica è stata impiegata per la prima volta come rivestimento per le navicelle spaziali. Questo è solo uno dei tanti esempi di come la tecnologia studiata e progettata per le missioni spaziali, possa arrivare sulla Terra, nelle nostre case, fra le nostre mani… e anche nelle nostre bocche.

Ora pensate ai caschi da motociclista dietro alla loro progettazione c'è lo studio svolto da fior fior di ingegneri che hanno messo a punto il casco spaziale, quello indossato dagli astronauti durante le missioni, composto da tre strati di una speciale plastica, con la visiera protettiva e la superficie anti-graffio. E sempre a proposito di caschi, anche l'elmetto da football americano ha una storia evolutiva legata allo spazio, infatti la speciale schiuma che c'è all'interno e che serve per attutire gli urti dei giocatori di football è stata in realtà concepita per rendere più confortevoli i sedili dello shuttle durante la fase di lancio.

E' grazie agli ingegneri della Nasa che la sala pesi della vostra palestra vi permette di mantenervi in forma, sì perché le attrezzature che utilizzate e, in particolare i pesi, sono stati progettati per l'allenamento dei muscoli degli astronauti.

Inutile dirvi che il joystick dei videogiochi viene concepito prima di tutto per la guida del Lunar Roving Vehicle, la navicella della missione Apollo per ispezionare il suono lunare. E solo in un secondo momento, viene utilizzato dai ragazzi per muovere sugli schermi dei computer il personaggio di un videogame.

Forse la tecnologia che più di ogni altra ha rivoluzionato e sta rivoluzionando le nostro vite è la tecnologia wireless. Il trapano a batteria che non necessita della corrente elettrica, usato per la riparazione della navicella spaziale, è stato in realtà realizzato per permettere agli astronauti di portare a terra un souvenir, cioè per bucare ed estrarre un pezzetto di suolo lunare. Oggi senza questa ingegnosa trovata non potremmo utilizzare i PC portatili, l'aspira-briciole e come dimenticare… i nostri inseparabili telefonini.

Ricerche infinite sui materiali tessili da portare nello spazio si traducono in vere e proprie scoperte utilissime per l'abbigliamento terrestre. Esempi? Le tute dei pompieri, ignifughe e resistenti alle condizioni più estreme hanno preso in prestito le tecnologie di protezione del corpo dalle tute astronautiche… ma non finisce qui… I materiali che permettono alle tute spaziali di essere isolanti e traspiranti al tempo stesso vengono impiegati anche per le tende da campeggio utilizzate nelle situazioni di emergenza dalla protezione civile.Il polipropilene della biancheria degli astronauti che raffredda la superficie corporea e permette l'evaporazione del sudore ha ispirato la realizzazione di abbigliamenti da lavoro come le uniformi della polizia, dei piloti aeronautici e anche quelle dei fornai!

Al contrario, erroneamente, si pensa che il velcro sia nato nei laboratori della nasa per la chiusura delle tute spaziali, di sicuro i bottoni non sono consoni per un viaggio su Marte… provate a pensare se dovesse staccarsene uno… ago e filo in micro-gravità non so come si comporterebbero…Ma dicevo… il velcro si pensa sia stato progettato per lo spazio, invece no, è stato inventato da un ingegnere svizzero nel 1941 al ritorno da un passeggiata in campagna. Arrivato a casa si accorse di avere dei minuscoli fiori rossi attaccati alla giacca. Colto dalla curiosità, li analizzò al microscopio e scoprì che erano fiori che sul calice avevano degli uncini, li studio e decise riprodurli artificialmente con il nylon. L'invenzione fu con successo brevettata bel 1955.

E chissà mai che tra poco non troveremo sulle nostre tavole sale e pepe in formato liquido, proprio come quello che utilizzano gli astronauti… non possiamo permetterci che la caduta accidentale di qualche granello di sale possa ostruire le preziosissime attrezzature spaziali o che un pizzico di pepe finisca nel naso degli astronauti, provocando fastidiose conseguenze… eccì!

venerdì 17 luglio 2009

CLIMANIMAL:lo scopo è di individuare le zone in cui le condizioni risultano rischiose per gli animali.

Loro, proprio come noi, soffrono il caldo.Ma sono sicuramente più vulnerabili. Sto parlando degli animali soprattutto quelli da allevamento. Uno studio dell' IBIMET (Istituto di Biometeorologia del CNR) ha individuato le zone del nostro paese in cui le condizioni meteorologiche sono più rischiose.Marina Baldi, la coordinatrice dell'istituto ci racconta che tipo di analisi meteorologiche sono state svolte e quali sono i risultati.

La ricercaL'Istituto di Biometeorologia del Consiglio Nazionale delle Ricerche (Ibimet-Cnr) partecipato al progetto CLIMANIMAL voluto dal Ministero delle politiche agricole alimentari e forestali, i cui risultati finali sono stati illustrati oggi a Viterbo. Il progetto ha lo scopo di individuare le zone sul territorio italiano in cui le condizioni termo-igrometriche possono essere rischiose per gli animali durante la stagione estiva

L'intensificarsi della frequenza con cui le ondate di calore colpiscono le nostre latitudini ed in particolare l'Italia ha portato ad un sempre maggiore interesse verso lo studio degli effetti che queste provocano sulla salute dell'uomo e degli animali. Uno studio recente ha mostrato che negli Stati Uniti le perdite economiche nel settore zootecnico, dovute alle ondate di calore possono essere comprese fra 1.69 e 2.36 miliardi dollari. Alcune stime parlano di un costo economico totale per l'Europa per l'evento 2003 di circa 12 miliardi di Euro, in gran parte dovuto alle perdite in agricoltura, incluso il settore zootecnico, dovute alla siccità e alla lunga ondata di calore verificatasi in quell'anno (da giugno a settembre, con brevi interruzioni), una delle più lunghe ed intense mai verificatesi nel nostro Paese. In particolare, nel campo dell'agricoltura e della zootecnia è noto che le condizioni ambientali, come la concomitanza di alte temperature ed umidità per più giorni consecutivi, possono causare condizioni di stress per gli animali e avere un impatto negativo sulla loro riproduzione, produzione e salute. Nel nostro Paese, in cui il numero di allevamenti di bestiame, sia piccoli che grandi, e' altissimo ed in cui la industria ad esso associata rappresenta una grossa fetta della economia nazionale, le perdite dovute a condizioni di disagio degli animali possono essere notevoli e, se questo e' vero per tutti gli animali da allevamento, lo e' ancor più per le vacche. L'Istituto di Biometeorologia ha partecipato ad un progetto di ricerca voluto dal Ministero delle politiche agricole alimentari e forestali, denominato CLIMANIMAL, i cui risultati finali sono stati illustrati nel corso di un Convegno che si è tenuto oggi a Viterbo, presso il Centro Congressi Pianeta Benessere, nel corso del quale sono state consegnate le targhe di partecipazione agli Allevatori coinvolti.Il progetto CLIMANIMAL - coordinato dal Dip.to di Scienze Animali della Università della Tuscia e a cui partecipano esperti nel campo della salute, produzione e riproduzione di questi animali quali AIA (associazione Italiana Allevatori) e ANAFI (Associazione Nazionale Allevatori Frisona Italiana) - ha lo scopo di individuare quali sono le zone sul territorio italiano in cui le condizioni termo-igrometriche possono essere rischiose per gli animali, ed in particolare per le vacche, durante la stagione estiva ed individuare eventuali strumenti di gestione delle situazioni di disagio e/o rischio dovuti a fattori climatici.Per far questo, l'IBIMET ha considerato la combinazione di due grandezze meteorologiche che sono la temperatura e la umidità dell'aria e ha ricostruito l'andamento del cosiddetto indice termoigrometrico o di disagio per 100 stazioni meteorologiche distribuite sul territorio nazionale per i mesi estivi, negli ultimi 30 anni. Nel caso in cui questo indice superi determinati valori di soglia, possiamo avere rischio Nullo, Minimo, Medio o Massimo.Il territorio italiano risulta quindi suddiviso in aree 'bioclimaticamente omogenee' e ciascuna zona e' stata assegnata ad una determinata 'classe' di appartenenza. Per ciascuna classe quindi e' stato calcolato il numero di giorni in cui l'indice di disagio nelle estati a partire dal 1971 fino al 2006 incluso ha superato i diversi valori di soglia.Per le zone in classe elevata, ad esempio, e' molto elevato il numero di giorni a rischio massimo, mentre le zone in classe bassa (classe 1 o 2) sono caratterizzate da un numero molto basso di giorni a rischio elevato. La pianura Padana, in cui si ha una altissima densità di allevamenti di bestiame e di caseifici, e', ad esempio, in una classe per cui il numero di giorni a rischio medio e/o massimo e' sufficientemente elevato.Dallo studio svolto all'Ibimet emerge inoltre una indicazione molto importante ovvero che il numero di giorni ad alto rischio che comportano quindi maggior disagio per il bestiame e' significativamente aumentato nel corso degli ultimi anni, a partire dal 2001, rispetto al periodo precedente (1971-2000), segno, presumibilmente, di un clima che sta cambiando.Questo risultato e', ai fini gestionali degli allevamenti, molto importante, in quanto indica come vi sia una alta probabilità che sia necessario adottare delle opportune contromisure, come, ad esempio, il raffrescamento delle stalle, una appropriata distribuzione di acqua e di mangime, operando sia sulla quantità che sulla qualità del mangime stesso, la necessita' di tenere il bestiame all'interno delle stalle piuttosto che al pascolo.IBIMET ha anche curato per tutta la durata del progetto la messa in opera e il funzionamento di otto stazioni meteorologiche presso altrettante aziende agricole laziali, nonché la raccolta ed elaborazione dati meteorologici raccolti. Ha quindi valutato l'andamento dell'indice termoigrometrico nei mesi estivi presso le aziende. Sono attualmente in corso di elaborazione le analisi della correlazione fra tale indice e le prestazioni e lo stato di salute degli animali. Lo studio proseguirà nel corso dell'estate 2009, in modo da avere un quadro più completo delle correlazioni.

I ricercatori del Nest di Pisa hanno ricreato la struttura del grafene all'interno di un semiconduttore, conferendogli eccezionali proprietà.

Scavando la superficie di un semiconduttore con un raggio di ioni, i fisici hanno ricreato su di essa una nanoscultura che, per forma, è indistinguibile dal grafene originale, arrivando a confezionare un prodotto fuori dal comune. Il grafene, infatti, è costituito di un singolo strato di atomi, tutti di carbonio e legati tra loro a nido d’ape, struttura che consente agli elettroni di muoversi al suo interno con estrema facilità e a velocità altissime (vedi Galileo). Attualmente, però, produrre grafene in grandi quantità non è possibile, perché non è facilmente lavorabile né scalabile (riproducibile in diverse scale, cioè misure).

Invece, il semiconduttore utilizzato dai ricercatori del Nest come supporto è in arseniuro di gallio, già impiegato nella costruzione di transistor veloci e laser; questo materiale è facilmente lavorabile e scalabile e, una volta assunta la forma del grafene, ne assume anche le proprietà fisiche. La ricerca ha ancora più valore dal momento che tutte le tecnologie e le apparecchiature utilizzate sono quelle comunemente impiegate nella nanofabbricazione a livello industriale.

“Siamo davvero felici di essere stati i primi ad aver realizzato il grafene artificiale”, hanno commentato Vittorio Pellegrini e Marco Polini del Nest: “Crediamo che questa ‘copia' già inserita in un semiconduttore - cioè proprio nel posto in cui la vuole l’industria - possa rendere le straordinarie proprietà del grafene più accessibili. Aver conseguito questo risultato ci permette di essere tra i primi a sfruttarne le possibili ricadute applicative”.

L'importanza dello studio, pubblicato nella sezione comunicazioni rapide di Physical Review B, è stata sottolineata anche dalla American Physical Society. (fe.f.)

Riferimento: Synopsis on Phys. Rev. B 79, 241406 (2009)

Y, cromosoma in via di estinzione

Individuato uno specifico gene che funge da interruttore per la produzione di anticorpi.

giovedì 16 luglio 2009

Veicoli in grado di scambiare tra loro informazioni sulle condizioni stradali.

SOURCE

SOURCEOrmai ogni macchina possiede dispositivi in grado di rilevare le condizioni di assetto e di comunicarle a un “cervello”, la centralina elettronica, che risponde per esempio agendo sull'impianto frenante o sugli ammortizzatori per aumentare la sicurezza e rendere più confortevole il viaggio. Perché, allora, non immaginare una rete in cui ciascun veicolo funge da sensore per gli altri? Per esempio per comunicare la presenza di una macchia d'olio o una curva particolarmente scivolosa per il fondo bagnato all'auto che segue. Sembra estremamente complicato e infatti lo è, però il dipartimento di meccanica del Politecnico ha già realizzato alcuni prototipi dotati di sensori all'interno dei pneumatici che rilevano le variazioni delle condizioni di marcia. Questi dispositivi utilizzano la vibrazione prodotta dall'auto in movimento come fonte di energia, e le onde radio come sistema di comunicazione.

Certo, migliaia di veicoli che inviano dati contemporaneamente potrebbero dar luogo a una ridondanza di informazioni, necessarie per alcuni ma irrilevanti per altri. “Le auto trasmetteranno segnali criptati, decifrabili da un sistema che filtrerà i dati in arrivo, permettendo di estrarre solo le informazioni utili”, spiega a Galileo Francesco Braghin, tra i responsabili del progetto.

L'idea è quella di creare un dialogo tra una rete mobile, gli autoveicoli - che rilevano le condizioni di marcia istante per istante interfacciandosi direttamente con i propri dispositivi e gli altri veicoli -, e una rete fissa, cioè le infrastrutture, che comunicano (sempre tramite onde radio e in tempo reale) la situazione della viabilità.

Lo scoglio più grande consiste nella realizzazione dei sensori: la rilevazione istantanea delle condizioni di marcia e aderenza pneumatico-fondo stradale, e la gestione ottimale del controllo di tutti i dati e la loro trasmissione rappresentano la sfida tecnologica dei prossimi mesi.

Altri sistemi, in studio presso i laboratori dell'Intel di Santa Clara (California), stanno utilizzando serie di impulsi laser velocissimi che codificano una sorta di linguaggio morse per far dialogare semafori e automobili e i veicoli tra loro. (a.d.)

mercoledì 15 luglio 2009

Archeologia: I tatuaggi di Oetzi erano fatti con la fuliggine.

Fonte: APCom

Fonte: APComSi tratta dei più antichi del mondo ed avevano scopi terapeutici Roma, 15 lug. (Apcom) - Era fatto con la fuliggine il più antico tatuaggio mai inciso su pelle umana: quello ritrovato su Oetzi, la mummia di un uomo morto 5300 anni fa e ritrovato nel ghiaccio nel 1991 ed oggi conservato in una cella frigorifera visibile al pubblico nel Museo Archeologico dell'Alto Adige di Bolzano. Di Oetzi gli scienziati hanno analizzato tutto, a cominciare dai suoi abiti, le armi e gli utensili ritrovati vicino a lui; hanno diagnosticato le sue malattie: l'artrite, problemi alla schiena e allo stomaco, ed è stato perfino sequenziato il suo genoma mitocondriale. Oggi i "laboratori" di tatuaggi offrono ai clienti una vasta scelta di coloranti: rossi contenenti mercurio, manganese per il porpora e perfino pigmenti che brillano al buio. Ma 5300 anni fa per i tatuaggi si usava per lo più fuliggine e non venivano fatti per bellezza, ma per scopi terapeutici, come potrebbe essere stato il caso di Oetzi. Lo afferma su Journal of Archeological Science , Maria Anna Pabst, una ricercatrice del Medical University di Graz, Austria , che ha eseguito sui tessuti epidermici dell'uomo di Similaun biopsie con il microscopio elettronico e ottico. Gli arti di Oetzi sono "disegnati" con croci e piccoli gruppi di linee parallele, alcune delle quali incise vicini ai punti dell'agopuntura. Per scoprire con che cosa erano stati fatti quei segni, Anna Pabst ha analizzato minutamente sottili sezioni di pelle prelevate dai tatuaggi ritrovati sull'uomo di Similaun e sezioni di pelle non tatuata. Le analisi sui frammenti di pelle tatuata hanno rivelato la presenza di numerose piccole particelle cosparse di cristalli di forma allungata. Relativamente alla composizione chimica, si è visto che queste particelle sono costituite essenzialmente di fuliggine, mentre i cristalli sono silicati. L'inchiostro di Oetzi, dice la ricercatrice, potrebbe essere stato grattato da rocce che si trovavano intorno ad un fuoco e contenenti silicati. Secondo la Pabst i confratelli di Oetzi potrebbero aver forato in profondità la pelle con una spina per iniettare l' inchiostro fatto con la fuliggine.

Uno studio rivela che l'aria è piena di funghi.

Fonte: Cordis

Fonte: CordisPer maggiori informazioni, visitare: Società Max Planck: http://www.mpg.de Università Johannes Gutenberg Mainz: http://www.uni-mainz.de/ PNAS: http://www.pnas.org

ARTICOLI CORRELATI: 27197, 30592

martedì 14 luglio 2009

I cicli orbitali ci dicono che andiamo verso una nuova glaciazione.

Le Ere Interglaciali sono periodi lunghi (milioni di anni), in cui non esistono ghiacci ai poli e separano due Ere Glaciali successive.

In glaciologia, la scienza che studia i ghiacciai, il termine glaciazione ( letteralmente azione, movimento dei ghiacci) è sinonimo di Era glaciale e indica un periodo di tempo in cui i poli della Terra sono ricoperti da calotte glaciali più o meno estese; secondo questa definizione ci troviamo ancora oggi in un periodo di glaciazioni, in quanto la Groenlandia e l'Antartico sono ancora ricoperte dai ghiacci. Più comunemente quando si parla degli ultimi milioni di anni della Terra, con glaciazioni ci si riferisce a lunghi periodi di abbassamento della temperatura (periodi glaciali particolarmente freddi) durante i quali le calotte glaciali si espandono in direzione dell'equatore fino a ricoprire gran parte dell'Europa e del Nord America. In questo senso l'ultima glaciazione è finita circa 10.000 anni fa.

L’alternarsi periodi glaciali e interglaciali è dovuto a particolari movimenti della Terra in particolare esistono alcuni "cicli millenari"(precessione degli equinozi e nutazioni dell’asse terrestre, rotazione della linea degli apsidi, rotazione della linea degli equinozi, variazione di eccentricità dell'orbita terrestre, traslazione del sistema solare nella galassia, traslazione della galassia nello spazio) che influenzano la quantità di radiazione solare che colpisce le differenti parti della terra nei diversi tempi dell'anno e nei vari periodi geologici. Altre possibili cause sono le eccezionali attività vulcaniche, l’intensità delle macchie solari, le variazioni nella composizione dell'atmosfera (gas serra),lo spostamento delle placche tettoniche,…

La presenza di numerosi ghiacciai e lo spesso manto di ghiaccio della Groenlandia e dell'Antartide stanno ad indicare che la Terra sta ancora attraversando un'era glaciale. C'è allora da chiedersi: quando l'Emisfero Nord entrerà di nuovo in un periodo di avanzamento dei ghiacci come quello che terminò 10-12.000 anni fa? I cicli orbitali ci dicono che andiamo verso una nuova glaciazione. Nel passato i cicli di forte glaciazione da 100.000 anni furono intervallati da un periodo interglaciale di 9-12.000 anni.

L'attuale periodo interglaciale ha circa 10.700 anni. Andiamo quindi incontro ad una ripresa della glaciazione. Tuttavia, nessun trend di breve periodo o di scala decennale o persino centennale riesce a rivelare con una certa affidabilità se stia per cominciare o meno una glaciazione. Ci sono stati almeno tre periodi ciclici di riscaldamento e raffreddamento all'interno dell'attuale periodo interglaciale. L'ottimo climatico ha raggiunto il suo picco 7.000 anni fa, quando la temperatura media dell'aria, dedotta dal volume di ghiaccio, era di 1,11 °C più alta del presente. è proprio quel periodo che lo studioso indiano B.G. Tilak indica come la data più recente possibile per la composizione dei Veda, quando l'Equinozio di Primavera era in Orione. La sua ipotesi dell'origine polare del gruppo linguistico indo-europeo, tuttavia, non esclude la datazione ad un più antico ciclo di precessione. I due lunghi cicli di riscaldamento che si sono verificati da 4.000 a 8.000 anni prima dell'attuale possono avere poco a che fare con l'effetto serra che si sostiene causato dalla produzione industriale di biossido di carbonio. Una Piccola Era Glaciale cominciò circa 650 anni fa e durò fino al diciannovesimo secolo. Da allora la Terra si è riscaldata lentamente, ma la temperatura media non si è mai avvicinata all'ottimo di 7.000 e 4.500 anni fa. Le ragioni di questi trend climatici più brevi non sono tutte ancora pienamente comprese. Tra i tanti fattori che occorre prendere più attentamente in considerazione ci sono la posizione della Terra nella galassia, i mutamenti nelle emissioni solari, le variazioni cicliche più piccole nell'orbita terrestre e le correnti oceaniche.

Il primo di questi tre fattori è probabilmente il più influente, e giocò un ruolo fondamentale soprattutto nella prima glaciazione, la più rigida di tutte.

La presenza di terre all'interno dei circoli polari artico e antartico appare necessaria per lo sviluppo di un' era glaciale, probabilmente perché le terre emerse forniscono uno spazio sul quale la neve e il ghiaccio si possono accumulare durante i periodi freddi.

L'orbita della Terra non ha una grande importanza come fattore scatenante di una glaciazione, ma sembra influenzare molto il susseguirsi dei periodi glaciali e interglaciali all'interno dell'attuale glaciazione.

Un'altra causa è data dal numero delle macchie solari, il cui numero influenza la temperatura terrestre.

lunedì 13 luglio 2009

L'industria della produzione della seta in Italia si sta spegnendo.

Fonte: Moebiusonline

Fonte: MoebiusonlineSilenziosamente, l'ultramillenaria industria della produzione della seta in Italia si sta spegnendo. Dapprima è stata la concorrenza con i grandi produttori asiatici a metterla in pericolo, poi, proprio quando gli aiuti comunitarii avrebbero potuto sostenere i nostri produttori, i bachi sono stati sterminati da un veleno utilizzato per liberare le coltivazioni di meli dai parassiti. Eppure i bachi sono creature straordinarie, potrebbero addirittura essere utilizzati per produrre proteine utili come farmaci. Ci racconta la loro storia Silvia Cappellozza, dell'Unità Ricerca di Api-Bachicoltura a Padova.

sabato 11 luglio 2009

Università di Firenze:Nuove ipotesi sulla correlazione tra HIV e AIDS (pubbl. su “Medical Hypotheses”)

Fonte: MET

Fonte: MET10/07/2009 13:34 Università di Firenze

Computer quantistico: dal Cesio la chiave per l'implementazione di super-algoritmi.

Fonte: Le Scienze

Fonte: Le ScienzeNel mondo classico, se ci si sposta dalla propria posizione di un passo a destra o a sinistra a seconda che esca testa o croce dal lancio di una moneta, si compie quello che viene detto un “cammino casuale”. Se si traccia su un grafico la frequenza della diverse posizioni assunte nel corso di un elevato numero di lanci della moneta, si ottiene una classica curva a campana. Il moto browniano ne è un altro esempio.

I fisici tedeschi hanno riprodotto questo esperimento a scala microscopica con un atomo di cesio. Gli atomi possono assumere differenti stati quantistici, analoghi alla testa e alla croce di una moneta, ma anche uno stato di sovrapposizione, ossia “un po' testa e un po' croce”.

Sfruttando fasci laser, i ricercatori hanno spinto un atomo di cesio in direzioni opposte: “In questo modo siamo stati in grado di muovere i due stati in direzioni distanti una frazione di millesimo di millimetro”, spiega Artur Widera, che ha diretto la ricerca. In seguito, hanno “lanciato la moneta” ancora una volta riportando le componenti in uno stato di sovrapposizione.

Dopo diversi ripetizioni di questo “cammino casuale quantistico”, l'atomo di cesio era stato stirato come se si trovasse un po' ovunque e solo nel momento della misurazione si “decideva” dove e in che stato esso si trovasse. Nella distribuzione delle probabilità della sua posizione interviene però in maniera significativa anche altro effetto quantistico, analogo a quello che nel caso della luce è chiamato interferenza, dovuto al fatto che alcuni stati possono rinforzarsi e altri annullarsi.

Ripetendo più volte l'esperimento, i ricercatori hanno quindi tracciato la curva della probabilità di presenza dell'atomo nei vari punti: “La nostra curva è chiaramente differente da quella ottenuta in un cammino casuale classico. Non ha un massimo al centro ma agli estremi”, nota Michal Karski, un altro degli autori. “Questo è ciò che ci si aspettava sulla base delle considerazioni teoriche, e che rende il cammino quantistico particolarmente attraente per le sue possibili applicazioni.”

“Con questo effetto abbiamo dimostrato che si possono realmente implementare algoritmi del tutto nuovi”, conclude Widera, ricordando che attualmente se si vuole individuare un “1” in una fila di “0” bisogna controllare ogni cifra singolarmente e il tempo necessario per farlo cresce linearmente con il numero di cifre. Sfruttando l'algoritmo della “cammino quantistico casuale” è invece possibile cercare nei diversi punti simultaneamente, abbattendo drasticamente il tempo di ricerca. (gg)

giovedì 9 luglio 2009

Fusione nucleare: Audio-intervista a Francesco Gnesotto,direttore del Consorzio RFX di Padova.

Fonte: Moebiusonline

Fonte: MoebiusonlineScarica l'intervista a Francesco Gnesotto

Un passo avanti verso la fusione nucleare è arrivato da Padova. Un grammo di idrogeno sottoposto a fusione produce milioni di volte più energia di quella che si produce bruciandolo. Perciò la fusione, come molti sanno, è la grande speranza del futuro per avere energia pulita e virtualmente illimitata. Attualmente c'è una specie di competizione per sviluppare la tecnologia più adatta, ma la direzione in cui si è andati più avanti, è decisamente una sola: il cosiddetto confinamento magnetico. Il punto, infatti, è che per realizzare la fusione bisogna prendere un gas di idrogeno e portarlo a temperature altissime, dell'ordine di decine o centinaia di milioni di gradi. In questo stato l'idrogeno è un plasma rovente e la difficoltà principale sta nel contenerlo; tenerlo chiuso da qualche parte, insomma. Attenzione: non nel senso che può esplodere. Anzi, il problema è mantenerlo acceso. Il contenimento del plasma è un gioco di equilibri molto delicato: appena qualcosa va storto il plasma si disperde, si raffredda e la reazione si spegne. E' un po' come tenere in equilibrio una scopa sulla punta delle dita: appena ci si allontana dall'equilibrio la scopa cade.

Ebbene, la notizia è che al consorzio RFX di Padova, dove si studiano i plasmi e si sperimenta un particolare tipo di confinamento magnetico - ce ne sono diversi. Questo è un dato importante per la nostra discussione - il gruppo guidato dal Prof. Piero Martin dell'Università di Padova e dalla Dr.ssa Maria Ester Puiatti del CNR, è riuscito a fare assumere a un plasma da fusione a 15 milioni di gradi una forma ad elica dotata di una sorta di equilibrio spontaneo. Insomma: qualcosa che renderebbe più facile contenerlo. Ci facciamo raccontare tutto da Francesco Gnesotto, direttore del consorzio RFX.

Sale a cinque il numero delle persone il cui genoma è stato completamente sequenziato.

Da Craig Venter e James Watson, analizzati nella loro "interezza" rispettivamente nel 2002 e nel 2008, i ricercatori continuano ad accumulare informazioni sulle piccole differenze genetiche tra le etnie, che si riflettono nella predisposizione alle malattie e nella risposta a farmaci. Lo spiega, in una lettera riportata sulla rivista inglese, il gruppo di ricercatori dell'Università di Seoul che ha sequenziato questo ultimo codice appartenente a un connazionale anonimo identificato con la sigla AK1. Gli studiosi riportano differenze nel numero e nelle caratteristiche di alcune parti di Dna rispetto ai quattro genomi umani già noti.

In particolare i ricercatori si sono concentrati sui cosiddetti “polimorfismi a singolo nucleotide” (o Snp, single nucleotide plomorphysm), ovvero i siti in cui un gene di un individuo si differenzia dallo stesso gene di un altro (o dal “modello base” più antico) per il cambiamento di una sola lettera.

Il numero di Snp individuate in AK1 è risultato pari a quello di James Watson, mentre è più alto di quello del codice cinese e meno rispetto a quello africano. Degli oltre nove milioni di Snp individuate in questi cinque genomi, circa l'8 per cento è comune a tutti. Il 21 per cento invece delle Snp di AK1 sono uniche e presenti in geni legati alle capacità sensoriali, ad alcune funzioni immunologiche e alla predisposizione a particolari malattie.

Ancora non è chiaro cosa comportino queste differenze, ma secondo i ricercatori sono molte sono le informazioni che si potranno ottenere studiando e comparando genomi provenienti da gruppi etnici diversi. Non solo per ripercorrere l'evoluzione della nostra specie e ricostruire le ondate migratorie, ma anche nell'ottica di una medicina sempre più personalizzata. (c.v.)

Riferimento: DOI: 10.1038/nature08211

mercoledì 8 luglio 2009

La chimica dei nano aggregati: dai laboratori al buco nell'Ozono.

Fonte: Moebiusonline

Fonte: MoebiusonlineC'è tutta una chimica sconosciuta, che fino a pochi anni fa non era nemmeno possibile esplorare, perché non esistevano gli strumenti adatti. Siamo, infatti, in uno di quei casi in cui è decisamente la tecnologia a stimolare nuova ricerca di base. Parliamo della chimica dei nano aggregati: cioè di una tutta una chimica che entra in gioco quando sono coinvolte poche molecole alla volta. E' una chimica che ha regole diverse da quella tradizionale, e tuttavia è alla base di numerosi fenomeni naturali. Per esempio, è implicata nella formazione del buco dell'Ozono.

Il primo anello della formazione del buco nell'Ozono è la dissociazione dell'acido cloridrico all'interno di gocce di acqua di pochi miliardesimi di metro, sospese nel gelo della stratosfera. Un dato riscontrato sperimentalmente, ma rimasto fin'ora senza una spiegazione. Nella stratosfera, la dissociazione dell'acido nelle nanogocce d'acqua catalizza - cioè favorisce e accelera - la creazione di cloro. È questo cloro che va poi a interagire con l'ozono causandone la scomparsa. Una reazione ben compresa dagli scienziati, tranne che per la sua prima fase: come può avvenire questa dissociazione nella stratosfera, dove la temperatura è bassissima? Perché vi sia una reazione, infatti, le molecole che vi prendono parte devono necessariamente avere sufficiente energia termica (calore) da interagire tra loro. Energia che certamente non posseggono nel gelo di quelle regioni.

Per risolvere questo enigma, i ricercatori hanno studiato la reazione grazie ai nanoaggregati, molecole piccolissime: le più piccole unità chimiche in grado di prendere parte a reazioni. Questi oggetti microscopici sono stati analizzati grazie a una tecnica innovativa, la spettroscopia infrarossa in elio superfluido, che consente di catturare in una goccia di elio le molecole che compongono il nanoaggregato nel quale avviene la reazione. L'elio è del tutto inerte chimicamente, così la piccolissima goccia diventa un vero e proprio "laboratorio microscopico", nel quale è possibile studiare in dettaglio la massa e le interazioni delle molecole che vi sono intrappolate. Raffreddando questo microlaboratorio al di sotto dei -272°, i ricercatori hanno finalmente potuto osservare "in diretta" il fenomeno di dissoluzione dell'acido.

La dinamica della dissociazione è semplice: quattro molecole di acqua e una di cloruro di idrogeno vanno ad interagire tra loro all'interno della nanogoccia. E il cloruro, cedendo un protone, fa si che si generi la più piccola goccia d'acido possibile. Ma da dove deriva l'energia per questa reazione? La spiegazione, sostengono gli scienziati, sta tutta in un fenomeno detto di aggregazione molecolare: molecole "lontane" fra loro - anche se dotate di poca energia termica - tendono ad attirarsi, e da questo processo di avvicinamento si genera proprio l'energia cinetica (e quindi termica) necessaria a causare la reazione. Uno degli aspetti più sorprendenti è che la dissociazione si verifica sempre e soltanto quando la quarta molecola d'acqua "cade" sull'acido cloridrico, che nel frattempo si è già legato ad altre tre molecole (vedi immagine).

Questo processo era ignoto, è cioè una nuova modalità con cui le molecole possono interagire a bassa temperatura, finora sconosciuta. Si tratta quindi un dato molto generale, che va al di là del caso specifico dell'Ozono. Per esempio, un tale processo potrebbe essere responsabile, almeno in parte, della formazione di molecole complesse nello spazio.

L'esperimento è stato condotto da ricercatori dell'Università tedesca di Bochum, mentre parallelamente, Marco Masi dell'INFM e dell'Università di Sassari, ha sviluppato la teoria e simulato la reazione al computer, fornendo così la chiave di lettura a quanto osservato. Lo studio si è guadagnato la pubblicazione su Science.

martedì 7 luglio 2009

Fusione nucleare: il futuro è nelle "mani" di DEMO e della Z-Machine.

Fonte: Wikipedia

Fonte: WikipediaLa macchina opera rilasciando un impulso elettrico associato ad un campo magnetico. L'energia risultante dalla scarica di 20 milioni di ampère vaporizza una schiera di sottili fili di tungsteno e un potente campo magnetico comprime il plasma prodotto. Questo, collassando, produce a sua volta raggi X che creano un'onda d'urto sul materiale in esame. La potente fluttuazione all'interno del campo magnetico (o impulso elettromagnetico) genera anche corrente elettrica in tutti gli oggetti metallici presenti nella camera.

Il nome Z machine deriva dal fatto che la corrente viaggia verticalmente verso l'oggetto in esame, lungo quello che convenzionalmente è chiamato "asse Z", essendo gli assi "X" e "Y" orizzontali (vedi la voce Z-pinch).

Originariamente progettata per fornire un'alimentazione di 50 terawatts in un unico e veloce impulso, i progressi tecnologici hanno consentito di raggiungere i 290 terawatts, sufficienti per lo studio della fusione nucleare. La macchina libera in 70 nanosecondi secondo 80 volte l'ammontare globale di potenza elettrica prodotta nel mondo. Tuttavia soltanto una piccola quantità di elettricità è consumata per ogni prova (pari a quella impiegata in 100 abitazioni per due minuti). Inoltre, prima dell'inizio del processo, si procede lentamente alla ricarica dei generatori Marx.

Il 7 aprile 2003 Sandia ha annunciato di aver realizzato la fusione del deuterio all'interno della Z machine. In seguito allo stanziamento di 60 milioni di dollari, nell'ambito del programma di rinnovamento annunciato nel 2004, la potenza in uscita della macchina verrà portata a 350 terawatts, mentre l'output per i raggi X raggiungerà 2,7 megajoule.

La Z machine è ora capace di spingere piccole piastre fino a 34 chilometri al secondo, più della velocità di rivoluzione della Terra nella sua orbita attorno al Sole (30 km/s), e un valore tre volte superiore alla velocità di fuga dal pianeta (11,2 km/s).

Nel 2005, la Z machine ha prodotto plasma con temperature al di sopra dei 2 GK (10^9 K) o 2 miliardi di °C. Gli scienziati del progetto erano dubbiosi riguardo agli esiti delle sperimentazioni, ma dopo quattordici mesi di analisi con modelli computerizzati e ulteriori esami, hanno concluso che i risultati siano effettivamente validi. Si crede che il plasma ad alta temperatura sia stato prodotto dall'uso di una bobina leggermente più grande del normale, composta da fili di acciaio poco più spessi degli usuali fili di tungsteno.

La lega di piombo con il 17% di atomi di litio (Pb-17Li) rappresenta un eutettoide, cioè una lega che fonde a temperature relativamente basse (vedi eutettico), la temperatura di fusione del Pb-17Li è di 235 °C, quindi il limite inferiore di temperatura per l'utilizzo di questa lega come vettore termico è di 250 °C, mentre il limite superiore, dato praticamente dalla resistenza meccanica dei materiali strutturali, è superiore a 600 °C nel caso di strutture in acciaio. Il Pb-17Li, essendo un conduttore elettrico, quando si muove in un campo magnetico, come quello generato in un reattore a fusione, è soggetto, oltre ai normali fenomeni fluidodinamici, anche a fenomeni magnetoidrodinamici, che possono aumentare sensibilmente la resistenza al movimento in queste condizioni, riducendo quindi la velocità con cui può muoversi nel tokamak.

L'elio, essendo gassoso, ha caratteristiche di scambio termico molto basse, quindi può essere utilizzato solo tenendo alte velocità e pressione, la pressione a cui si fa riferimento negli studi di DEMO è di 8 MPa. Questa elevata pressione del gas limita la massima temperatura di impiego a circa 500 °C in strutture resistenti di acciaio, mentre può essere aumentata utilizzando come materiali strutturali metalli refrattari (particolarmente Tungsteno).

Il vettore termico, dopo essere stato riscaldato dalla reazione di fusione viene portato fuori dal recipiente di contenimento del vuoto (vacuum vessel - VV) e, nel caso del Pb-17Li, cede il calore ad un gas che viene utilizzato in una turbina, che, muovendo un alternatore, genera l'energia elettrica. Il passo intermedio dello scambio di calore con un gas per utilizzarlo in turbina naturalmente è assente nel caso dell'elio.

lunedì 6 luglio 2009

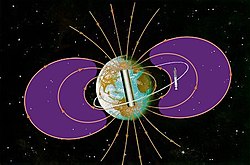

Fasce di van Allen: Cosa sono? Quali pericoli comportano per il genere umano?

Fonte: Wikipedia

Fonte: WikipediaDa un punto di vista qualitativo, è utile notare che la fascia di van Allen consiste in realtà di due fasce che circondano il nostro pianeta, una interna ed una più esterna. Le particelle cariche sono distribuite in maniera tale che la fascia interna consiste principalmente di protoni, mentre quella esterna consiste principalmente di elettroni.

Sebbene il termine fasce di van Allen si riferisca esplicitamente alle cinture che circondano la Terra, simili strutture sono state osservate attorno ad altri pianeti. Il Sole, al contrario, non possiede fasce di radiazioni durevoli nel tempo.

L'atmosfera terrestre limita inferiormente l'estensione delle fasce ad un'altitudine di 200-1000 km; il loro confine superiore non arriva oltre i 40.000 km ( che corrispondono a circa 7 raggi terrestri) di distanza dalla superficie della Terra. Le fasce si trovano in un'area che si estende per circa 65 gradi a Nord e a Sud dell'equatore celeste.

La fascia esterna contiene diversi tipi di particelle, fra cui elettroni e numerosi ioni. La maggior parte degli ioni compare sotto forma di protoni energetici, ma vi è anche una certa percentuale di particelle alfa e di ioni di ossigeno O+, simili a quelli presenti nell'atmosfera ma assai più energetici. La presenza di diverse categorie di particelle suggerisce che la fascia sia generata dalla concomitanza di diversi fenomeni.

Rispetto alla fascia interna, quella esterna è più estesa ed è circondata da una regione a bassa intensità nota come ring current. Essa contiene inoltre una maggiore varietà di particelle ed è caratterizzata da un livello di energia minore (meno di 1 MeV), che aumenta significativamente solo quando una tempesta magnetica provoca la risalita di nuove particelle dalla magnetosfera.

Il merito della scoperta della fascia esterna è conteso fra gli Stati Uniti (con l'Explorer 4) e l'Unione Sovietica (con gli Sputnik II/III).

La separazione fra la fascia interna e quella esterna è causata dalla presenza di onde radio a bassa frequenza che respingono le eventuali particelle che potrebbero venirsi a trovare in tale regione. Tempeste magnetiche particolarmente intense possono spingere delle particelle cariche in questa zona, ma entro pochi giorni l'equilibrio viene ristabilito. Si pensava inizialmente che queste onde radio fossero generate da turbolenze presenti nelle fasce stesse, ma un recente studio ad opera di James Green, del Goddard Space Flight Center della NASA, ha evidenziato un legame con le misurazioni dell'intensità e della distribuzione dei fulmini effettuate dal satellite Micro Lab 1.

In passato l'Unione Sovietica accusò gli Stati Uniti di aver dato origine alla fascia di van Allen interna a seguito di test nucleari effettuati nel Nevada; allo stesso modo, l'URSS stessa è stata accusata dagli statunitensi di aver generato la fascia esterna. Non è chiaro come gli effetti degli esperimenti nucleari avrebbero potuto superare l'atmosfera e raggiungere l'altitudine che caratterizza le fasce di radiazioni; certamente non è stata osservata alcuna diminuzione apprezzabile della loro intensità da quando i test nucleari nell'atmosfera sono stati banditi per trattato.

Una recente proposta da parte di Robert Forward, nota come HiVolt, suggerisce un metodo per portare nel giro di un anno il livello della fascia interna all'1% di quello attuale. La sua proposta comporta il dispiegamento di trappole elettricamente cariche in orbita; in questo modo gli elettroni dovrebbero essere deflessi dal campo elettrostatico generato artificialmente e dovrebbero disperdersi senza danni.