Notizie e curiosità in ambito scientifico. Un blog di Fausto Intilla (teorico, aforista, inventore e divulgatore scientifico).

martedì 31 marzo 2009

lunedì 23 marzo 2009

La fusione nucleare fredda di Yoshiaki Arata

1994-2008, Esperimenti di Yoshiaki Arata

1998, Fusione fredda dalla cella ad altissima pressione DS Cell:

Yoshiaki Arata e Zhang, nel 1998, hanno confermato, dopo un lavoro durato diversi anni, proveniente dalla cella immersa in acqua pesante (deuterio) (D2O), un notevole eccesso di energia, superiore agli 80 watt (1,8 volte maggiore dell'energia utilizzata per sostenere tale reazione) per 12 giorni. I due ricercatori hanno poi affermato che l'energia emessa durante tali esperimenti, era troppo grande, in comparazione alla piccola massa dei materiali utilizzati dentro la cella, da giustificare come conseguenza di una eventuale reazione di tipo chimico. La cella ideata da Arata, diversamente ad altre utilizzate nella fusione fredda Palladio-Deuterio, è molto particolare in quanto opera con elevatissime pressioni.Successivamente, nel 2006, alcuni ricercatori italiani del'ENEA di Frascati, hanno ripetuto una parte dell'esperimento di Arata, confermando la presenza di un forte aumento di pressione all'interno di un tubo, immerso in una particolare soluzione liquida, tramite il passaggio di una corrente faradica.

2008, La cella a gas di deuterio:

Successivamente Arata osservava che una notevole quantità di energia utilizzata per attivare la reazione veniva dissipata dall'elettrolita sotto forma di semplice riscaldamento. Perciò, successivamente, ha sviluppato una particolare cella senza elettrolita e senza alimentazione elettrica, la quale, anche se apparentemente molto differente dalle precedenti celle, in pratica non se ne discosta molto dai principio base di funzionamento.

Arata, nel maggio 2008, ha comunicato alla comunità scientifica internazionale, di aver terminato di perfezionare un protocollo, di produzione di energia da fusione fredda, potenzialmente capace di produrre quantità rilevanti di energia. Tale protocollo utilizza un originale sistema composto da particolari nano-particelle di Palladio disperse in una matrice di zirconio. Con complesse procedure di metallurgia, viene ossidato lo Zirconio, ma non il palladio, in modo che quest'ultimo sia disperso all'interno di una matrice amorfa di ossido di zirconio che se da un lato risulta permeabile al deuterio, dall'altro impedisce alle nanoparticelle di palladio di raggrupparsi. L'esperimento di Arata inizia saturando l'atmosfera della cella con deuterio, il quale, velocemente, attraversa la matrice di zirconio venendo quindi assorbito dalle nanoparticelle di palladio, caricandole e quindi portandole alle condizioni critiche per le quali si innescano probabili fenomeni di fusione nucleare.Secondo Arata, una volta avviato il processo di fusione, il sistema così realizzato, è capace di azionare un motore termico, senza nessun altro apporto di energia.

22 maggio 2008, dimostrazione presso l'università di Osaka:

Il primo esperimento pubblico, in cui erano presenti circa 60 persone, tra scienziati e giornalisti, aveva come fine quello di dimostrare la riproducibilità del 100% dei fenomeni di produzione di calore da parte della cella a gas di deuterio in pressione, sviluppata da Arata e dal suo collaboratore Yue-Chang. L'evento ha avuto luogo il 22 maggio 2008, all'Università di Osaka, con una dimostrazione completamente in lingua giapponese. La cella è stata caricata con 7 grammi di speciali nanoparticelle, messa sotto pressione con deuterio a 50 atmosfere, iniziava immediatamente a produrre energia termica, senza nessun tipo di alimentazione elettrica. L'energia termica prodotta, qualche decina di watt, era sufficiente a mettere in moto un motore termico a ciclo di Stirling. Al termine dell'esperimento i presenti hanno voluto nominare tale fenomeno con il nome di Arata Phenomena.

L'esperimento avvenuto il del 22 maggio 2008, nell'Università di Osaka, è stato eseguito con questo protocollo:In un apposito contenitore a pressione, posto all'interno di un calorimetro e collegato, per mezzo di una tubazione, ad uno spettrometro di massa ad altissima risoluzione (Necessario per dimostrare la presenza di 4He (Elio 4), come eventuale residuo della reazione di fusione), sono stati inseriti 7 grammi di di nano-particelle di Palladio disperse in una matrice di Ossido di Zirconio appositamente preparate dal laboratorio di Arata. Nella prima fase del test, in tale recipiente, è stato inserito idrogeno a 50 atmosfere, generando così un breve picco termico dovuto alla idratazione delle stesse, seguito poi da un lento raffreddamento, dimostrando così che in tale situazione non vi è ne emissione di calore, ne presenza di 4He. Il recipiente è stato poi svuotato, degasato e nuovamente riempito, ma questa volta con deuterio a 50 atmosfere. A questo punto vi è stato di nuovo il picco termico dovuto alla idratazione (il deuterio, essendo un isotopo dell'idrogeno, si comporta chimicamente allo stesso modo), ma questa volta il calore, non è andato via via scemando, ma è continuato in modo costante, tanto da permettere il funzionamento di un motore termico a ciclo di Stirling. Il funzionamento è proseguito per diverso tempo, in modo da poter accumulare nel sistema una sufficiente quantità di elio, successivamente è stata fatta una nuova misura del gas presente nel contenitore e questa volta, lo spettrometro di massa, ha rilevato nettamente la presenza di elio mescolato con deuterio, segno evidente che il calore prodotto era dovuto ad una reazione termonucleare. Durante la reazione, gli appositi rilevatori di radiazioni, non hanno rilevato nessuna emissione radioattiva.Arata, ha fatto notare, durante la conferenza che aveva preceduto l'esperimento, che tale esperimento prova in modo assolutamente evidente la capacità di produzione di discrete quantità di calore attraverso una reazione di fusione fredda, ma che comunque rimangono ancora aperti numerosi problemi per lo sfruttamento commerciale di tale tecnologia. I problemi più importanti da superare sono quelli legati al degasaggio dell'elio che si è formato all'interno delle nano-particelle, in quanto il suo accumulo in un certo qual modo avvelena la reazione, ed alla necessità di ricercare un materiale meno costoso e più abbondante del palladio utilizzato per l'esperimento.

Alcuni ricercatori hanno criticato la validità della dimostrazione di Arata sopratutto in relazione al fatto che Arata non ha pubblicato i risultati su nessuna rivista scientifica soggetta a revisione paritaria.

I limiti della ricerca dei pianeti extrasolari

Grazie al suo ampio specchio e alla sua posizione nello spazio, il James Webb Space Telescope (JWST, il cui lancio è previsto per il 2013) offrirà agli astronomi la prima vera possibilità di trovare altre risposte, ma occorre tenere conto di alcune limitazioni fondamentali.In un nuovo studio, Lisa Kaltenegger dell'Harvard-Smithsonian Center for Astrophysics e Wesley Traub del Jet Propulsion Laboratory hanno esaminato la capacità del JWST di caratterizzare l'atmosfera di un ipotetico pianeta di tipo terrestre durante il transito di fronte alla sua stella, quando parte della luce della stella viene filtrata dall'atmosfera del pianeta.In un evento di transito, un pianeta extrasolare distante incrocia la direzione di osservazione dalla Terra: nel corso di tale processo, i gas presenti nella sua atmosfera assorbono una piccola frazione della luce della stella. In base allo spettro di assorbimento misurato è possibile ricavare le specie chimiche presenti.Si è così riscontrato che il JWST sarebbe in grado di rivelare alcuni gas chiamati biomarcatori, come l'ozono e il metano, solo per i pianeti molto vicini alla Terra."Anche sapendo già che si tratta di un pianeta di tipo terrestre dovremmo essere veramente fortunati per caratterizzarne l'atmosfera”, ha spiegato Kaltenegger. "Occorreranno molti transiti per arrivare a qualcosa; forse centinaia, anche per stelle distanti solo 20 anni luce.”Lo studio di Kaltenegger e Traub, accettato per la pubblicazione sulla rivista “The Astrophysical Journal” e disponibile online, ha preso in considerazione pianeti di tipo terrestre in orbita intorno a stelle simili al Sole: per ottenere un segnale rivelabile da un singolo transito, la stella e il pianeta dovrebbero essere molto vicini alla Terra. L'unica stella candidata è Alfa Centauri A, ma in tal caso non è stato trovato alcun pianeta, sebbene la tecnologia per rivelare i pianeti simili al nostro sia disponibile da poco tempo.Lo studio considera poi i pianeti in orbita intorno a stelle classificate come nane rosse, chiamate anche di tipo M. queste sono le più abbondanti nella Via Lattea, molto più comuni di quelle gialle, o tipo G, come il Sole. Esse sono più fredde e fioche del Sole, il che rende la scoperta di un pianeta che transita di fronte a una stella M molto più facile.“Le nane rosse vicine offrono la migliore possibilità di rivelare biomarcatori in un evento di transito”, ha commentato Kaltenegger. "Infine, lo studio delle immagini dirette, ovvero l'analisi dei fotoni potrebbe rivelarsi un metodo ancora più efficace della tecnica di transito per caratterizzare l'atmosfera di tipo terrestre”. (fc)

Nuovi vaccini a base di glicani

sabato 21 marzo 2009

PNA (Peptide Nucleic Acid): Una nuova molecola della vita

È stato ipotizzato che le prime forme di vita sulla Terra possano aver utilizzato il PNA come materiale genetico, grazie alla sua robustezza, passando poi ad un sistema basato su DNA ed RNA.

Il PNA viene rappresentato come un peptide, con l'azoto-terminale in prima posizione (a sinistra) ed il carbonio-terminale in ultima posizione (a destra).

Poiché lo scheletro del PNA non contiene gruppi fosfato carichi, il legame tra filamenti PNA/DNA è più forte di quello DNA/DNA, grazie alla minore repulsione elettrostatica. I primi esperimenti con filamenti di omopirimidina (formati soltanto da ripetizioni di pirimidina) hanno mostrato che la temperatura di fusione di una doppia elica composta da un frammento di PNA formato da 6 timine legato al corrispettivo DNA di 6 adenine è di 31 °C, mentre la doppia elica DNA/DNA corrispondente viene denaturata a temperature inferiori a 10 °C. Le molecole di PNA con basi miste imitano perfettamente le molecole di DNA in termini di riconoscimento delle coppie di basi. I legami della doppia elica PNA/PNA sono ancora più forti di quelli PNA/DNA (a loro volta più forti di quelli DNA/DNA).

Le molecole di PNA non sono riconosciute né dalle nucleasi né dalle proteasi: per questo motivo sono dunque resistenti alla degradazione enzimatica. I PNA sono stabili anche in un largo range di pH. Infine la loro natura elettricamente neutra potrebbe facilitarne il passaggio attraverso la membrana cellulare, aumentandone il valore terapeutico.

Gli oligomeri di PNA vengono comunemente usati in esperimenti di biologia molecolare, test diagnostici e terapie antisenso. Grazie all’elevata forza di legame non è necessario costruire lunghi oligomeri di PNA, normalmente infatti è sufficiente un PNA di 20-25 basi per ottenere dei buoni oligonucleotidi sonda. Si ritiene anche che i PNA possano avere in futuro un ruolo molto interessante a livello terapeutico.

giovedì 19 marzo 2009

Una nuova sfida per IBM: "hstp", ovvero "hyper-speech transfer protocol".

Un sistema del genere potrà sembrare rozzo e inefficiente per chi è abituato alle meraviglie multimediali della banda larga. Ma i telefonini si stanno diffondendo a velocità sorprendente in zone, come l'Africa povera e l'India rurale, dove i computer e l'internet veloce sono ancora molto di là da venire. Ed è proprio a queste realtà che si rivolge il progetto Ibm. I ricercatori sono convinti che l'adozione del nuovo protocollo, attualmente in sperimentazione in alcune regioni dell'India, sarà spinta dalla facilità d'accesso e dalla possibilità per chiunque di creare in pochi passi il proprio sito vocale. Eppure, le ricadute della ricerca potrebbero essere ben più ampie: si è da tempo diffusa la convinzione che le tastiere, così come sono configurate attualmente, non siano lo strumento adatto per comandare computer e telefonini in mobilità. L'idea che la voce possa un giorno sostituirsi ai tasti è un vecchio cavallo di battaglia, fra gli altri, del fondatore di Microsoft Bill Gates. Google ha recentemente introdotto la possibilità, per chi naviga con l'Apple iPhone, di effettuare ricerche parlando nel microfono del cellulare. Se l'hstp avrà la capacità, non di sostituirsi, ma di sovrapporsi alla rete come la conosciamo oggi, potrebbe aprirsi un nuovo scenario nell'interazione tra i navigatori e internet.

(19 marzo 2009)

Nanosistemi Produttivi (Dalle molecole ai superprodotti)

Comunicare il potenziale della nanotecnologia e della produzione molecolare é molto più semplice se li si fa "vedere". Per questo Nanorex Inc. (http://www.nanorex.com) ed il Foresight Institute (http://www.foresight.org) hanno collaborato alla realizzazione di una breve animazione al computer denominata "Nanosistemi produttivi: dalle Molecole ai Superprodotti". Questa animazione nasce dalla collaborazione tra l'ingegnere e autore John Burch (http://www.lizardfire.com) ed il pioniere della nanotecnologia, Dr. K. Eric Drexler (http://www.e-drexler.com). Vedrete una "nanofabbrica" in azione e i passi più importanti del processo che, partendo da semplici molecole, produce un computer con un miliardo di CPU.Per ulteriori informazioni (in inglese): www.nanorex.com

mercoledì 18 marzo 2009

L'orologio dei batteri

Redazione MolecularLab.it (18/03/2009)

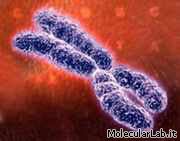

I telomeri codificano RNA

I telomeri non sono costituiti da DNA silente, la scoperta potrebbe aprire nuove strade allo studio e alla cura dei tumori.

I telomeri - porzioni di DNA che si trovano alle estremità dei cromosomi e che si accorciano ogni volta che la cellula si divide dando il segnale di blocco della divisione quando diventano troppo corti - contengono molecole che vengono trascritte in RNA. E' questa la scoperta, pubblicata su "Science Express", realizzata da un gruppo di ricercatori dell'Università di Pavia e dello Swiss Institute for Experimental Cancer Research (ISREC), coordinati da Elena Giulotto e Joachim Lingner. Poichè finora si pensava infatti che i telomeri fossero "silenti", ossia che il loro DNA non venisse trascritto in filamenti di RNA, la scoperta rimette in discussione tutto il meccanismo con cui si ritiene che funzionino i telomeri e potrebbe fornire una nuova via di intervento per bloccare la rigenerazione continua e incontrollata dei telomeri che si verifica nelle cellule cancerose. Nelle cellule embrionali e in alcune staminali, l'enzima telomerasi provvede a ricostituire i telomeri, in modo che esse possano continuare a dividersi ma col tempo la telomerasi si "usura" e quindi i telomeri si accorciano fino al punto in cui viene bloccata la divisione cellulare. Nelle cellule cancerose l'azione della telomerasi continua con efficienza, rendendole "immortali" grazie a un meccanismo di cui questa ricerca inizia a chiarire le fasi.

Redazione MolecularLab.it (18/03/2009)

La formazione delle sinapsi dipende dalla netrina

martedì 17 marzo 2009

Una nuova tecnica per il profilo epigenetico

FONTE

La tecnica, descritta su Development Cell, permette di individuare il profilo epigenetico, cioè i meccanismi di regolazione del Dna, e le alterazioni a suo carico che causano patologie come il cancro.

Nel nostro organismo ogni cellula ha un patrimonio di circa 30 mila geni ereditati dai genitori. Affinché ciascuna cellula assuma un ruolo specifico - neurone, del sangue, epatica... - solo una parte di questi geni viene espressa, mentre gli altri vengono silenziati. Questo meccanismo selettivo, alla base della differenziazione, avviene tramite processi chimici che attivano alcuni geni e ne reprimono altri, senza alterare la sequenza del Dna.

A carico di questi meccanismi di regolazione, quindi a livello epigenetico, possono verificarsi le alterazioni che portano allo sviluppo dei tumori. Tali mutazioni, a differenza di quelle genetiche che avvengono nella sequenza del Dna, sono reversibili se trattate con farmaci. Da qui l’importanza di una tecnica che fornisca il profilo epigenetico di un paziente in tempi brevi, permettendo terapie personalizzate.

Il metodo realizzato dall’équipe di Saverio Minucci, del dipartimento di Oncologia sperimentale dell’Ifom-Ieo di Milano, si basa su un tipo di tecnologia “high throughput”, che consente di individuare in tempi molto veloci la frazione di Dna “attivo” (non silenziato) in ciascun tipo di cellula. Sperimentata in vivo su un milione di cellule umane, la tecnica ha fornito uno screening epigenetico affidabile al 90 per cento. Un buon risultato, se si pensa che altre tecnologie in fase di sviluppo richiedono un campione di cellule fino a cento volte superiore e forniscono dati che hanno un'affidabilità del 30 per cento appena.

Allo stato attuale i test sono condotti su individui sani affinché si possa avere una mappa del profilo epigenetico “normotipo”. Il passo successivo sarà quello di applicare l’analisi a pazienti affetti da patologie tumorali, ed individuare così le alterazioni epigenomiche coinvolte (r.p.).

Tevatron: nuovi risultati sul Bosone di Higgs (non può esistere tra i 160 e i 170 GeV/c2)

FONTE

FONTESembra restringersi il territorio di caccia per stanare la particella di Higgs, la più ricercata dai fisici di tutto il mondo.

Sono due gli esperimenti che hanno portato a questi risultati: quello denominato CDF, Collider Detector at Fermilab, cioè un rivelatore di particelle elementari che analizza i risultati delle collisioni protone- antiprotone; e quello noto come DZero, che rivela le collisioni in un altro punto della folle corsa delle particelle e si avvale di altri strumenti tra i quali un calorimetro a campionatura ad argon liquido. Combinando i risultati dei due esperimenti, i fisici aumentano i dati a loro disposizione per verificare le caratteristiche delle particelle previste dal cosiddetto Modello Standard. È questo il modello attualmente più accreditato per spiegare il microcosmo riducendolo a pochi componenti elementari, suddivisi in particelle pesanti (come i protoni e i neutroni), in quelle leggere come gli elettroni, in quelle di massa quasi nulla come i neutrini; e poi ci sono i fotoni, che trasportano tutti i tipi di radiazioni e inoltre una serie di particelle esotiche di materia e antimateria. In questo quadro c’è posto, almeno teoricamente, per il bosone di Higgs del quale però non si è ancora riusciti ad catturare le impronte rivelatrici. Quello che i due esperimenti del Fermilab sono riusciti a misurare sono i dati di un certo numero di collisioni utili: finora hanno analizzato un terzo degli impatti e ciò è stato sufficiente per poter dedurre quella previsione che esclude la zona alta delle energie possibili per la cattura di Higgs.

Se queste previsioni saranno confermate, la conseguenza più evidente è che la caccia alla celebre particella diventerà più difficile: infatti, se abbiamo a che fare con energie più basse, le particelle prodotte nel decadimento della particella saranno più facilmente confondibili con tante altre che contribuiscono a creare una sorta di “rumore di fondo” subatomico. Quindi l’evento, che potrebbe svelare i segreti della materia, risulterebbe essere mascherato e molto difficile da evidenziare con chiarezza.

Non si può comunque dire che si tratti di una brutta notizia: fa parte della normale avventura di chi indaga la realtà naturale che è quella che è: Ed è anche inutile alimentare la polemica se questi risultati potranno avvantaggiare il Tevatron o l’LHC nel giungere per primo a tagliare l’atteso traguardo. In entrambi gli schieramenti l’atmosfera resta di ottimismo e la convinzione di poter sparare il colpo decisivo non subisce tentennamenti. Si tratterà piuttosto di affinare ancor più le tecniche e gli strumenti, sia pratici che teorici, per far fronte a una sottigliezza e imprevedibilità della natura che non smette di sorprendere gli scienziati e di stimolare la loro creatività.

Batterie cariche in dieci secondi

Ormai da vent’anni la tecnologia che utilizza accumulatori al litio è impiegata nella maggior parte delle apparecchiature portatili. La leggerezza e l’alta capacità di accumulo di energia hanno infatti reso vincenti sul mercato queste batterie, che però presentano lunghi tempi di ricarica perché la migrazione degli ioni litio dal catodo all'anodo (cioè da un polo all'altro della a un polo della batteria) è un processo relativamente lento.

Byoungwoo Kang e Gerbrand Ceder hanno però trovato il modo di accelerarlo, come spiegano sull'ultimo numero di Nature (qui il link allo studio). I due ricercatori hanno riscoperto un materiale già utilizzato negli accumulatori, il litio ferro fosfato. Il catodo delle nuove batterie è infatti costituito da piccolissime nanosfere - dell’ordine di 50 nanometri - di questo materiale, ricoperto poi da un sottile strato di litio fosfato. Le nanosfere rilasciano rapidamente gli ioni litio quando la batteria si carica, che viaggiano attraverso l'elettrolita (il mezzo che separa i de poli) verso l'anodo. Quando la batteria si scarica, gli ioni viaggiano in senso inverso per essere riassorbiti dalle nanosfere, circondate da carbonio che implementa ulteriormente la velocità a cui si muovono le cariche.

I ricercatori hanno calcolato che per ricaricare un cellulare bastano dieci secondi, e cinque minuti per un'auto ibrida, a fronte delle attuali otto ore. (a.d.)

ZP3: La proteina della fecondazione

La forsennata corsa degli spermatozoi verso l'oocita da fecondare, quando è coronata dal successo, termina con l'aggancio a una proteina presente sulla superficie della meta: si chiama ZP3 ed è nota da circa trent'anni. Non è ancora nota invece la sua struttura tridimensionale: una informazione fondamentale sia se si vogliono diagnosticare cause di infertilità sia per progettare anticoncezionali che agiscano sulla fecondazione invece di basarsi sugli ormoni (agendo quindi sulla maturazione dell'oocita), come quelli oggi disponibili. Un primo passo è stato compiuto da un gruppo di ricercatori del Karolinska Institutet di Stoccolma, autori di uno studio ZP3 appena pubblicato su Nature. Ne parliamo con Luca Jovine, parte del gruppo di ricerca di Stoccolma.

Ascolta l'intervista a Luca Jovine

Nanosonde antitumorali

Identificata la "firma" della coscienza

Quattro specifici, distinti processi si combinano per dare luogo alla "firma" che contraddistingue quell'attività cerebrale che noi esperiamo come coscienza. Lo dimostra una ricerca pubblicata sull'ultimo numero della rivista on line ad accesso pubblico PLoS Biology in cui Stanislas Dehaene, Lionel Naccache, Raphael Gaillard e collaboratori dell'INSERM, a Gif sur Yvette, in Francia, hanno studiato l'attività cerebrale di persone a cui erano stati presentati due differenti tipi di stimoli, uno percepibile coscientemente, l'altro no. L'esperimento è stato possibile grazie alla collaborazione di diversi pazienti che per la terapia di gravi forme di epilessia dovevano comunque essere sottoposti a un intervento per il posizionamento di una serie di micro-elettrodi nel cervello, rendendo così possibile la registrazione, con una risoluzione spaziale e temporale mai ottenuta in precedenza, dell'attività elettrofisiologica intracerebrale. I ricercatori hanno presentato loro su un monitor una serie di parole "mascherate" e non mascherate mentre misuravano i cambiamenti nell'attività cerebrale e il livello di consapevolezza della loro visione delle parole. Confrontando la risposta elettrofisiologica dei neuroni ai due differenti tipi di stimoli, i ricercatori hanno così potuto isolare quattro differenti marcatori elettrofisiologici fra loro convergenti e complementari che caratterizzano l'accesso di un'informazione alla coscienza 300 millisecondi dopo la percezione. Tutte le misure hanno lasciato intravedere un coinvolgimento in uno stato di riverberazione di attività cerebrale a vasto raggio. "Questo lavoro suggerisce che una più matura concezione dei processo di coscienza dovrebbe considerare, invece di un unico marcatore (il correlato neuronale della coscienza). Uno schema di attivazione distribuito e coerente dell'attività cerebrale", spiega Lionel Naccache. I risultati vanno a corroborare il modello di coscienza che prevede l'esistenza di uno spazio di lavoro globale, e che ipotizza che un'informazione in arrivo diventi cosciente quando vengono soddisfatte tre condizioni. In primo luogo, l'informazione deve essere rappresentata da reti di neuroni sensoriali, come quelli della corteccia visiva primaria. Inoltre, la rappresentazione deve durare sufficientemente a lungo per avere accesso al (o "arrivare all'attenzione del") secondo stadio di elaborazione distribuita nella corteccia cerebrale, il principale centro di associazione fra tipi differenti di informazione. Infine, questa combinazione di propagazione dell'informazione "dal basso verso l'alto" e di amplificazione dell'informazione "dall'alto verso il basso" deve innescare, attraverso l'attenzione, un'attività coerente fra differenti centri cerebrali. Attività coerente che sarebbe quella, secondo il modello, che esperiamo come coscienza. Gli autori sottolineano che, secondo questo modello, la coscienza è sempre coscienza "di" qualcosa e che non esiste uno stato di coscienza "puro" svincolato dal contenuto del pensiero. (gg)

lunedì 16 marzo 2009

GIAPPONE: Shuji Kajida presenta Ucroa, la modella-robot

TSUKUBA (GIAPPONE), 16 Marzo 2009 - Naomi Campbell confessa di sentirsi vecchia e si preoccupa per il diradarsi delle chiamate del suo agente. Quando ha parlato col mensile GQ, però, la supermodella non aveva ancora preso in considerazione l’avvento di Ucroa, la modella-robot. Una equipe giapponese dell’Istituto di tecnologie industriali avanzate (Aist) ha investito tre anni di lavoro e 200 milioni di yen (1,6 milioni di euro) per la creazione di un robot umanoide in grado di affrontare le passerelle. Il risultato è un prototipo che ha il nome tecnico di Ucroa. La taglia è ben diversa da quella della statuaria ‘venere nerà, d’altra parte è stata creata pensando allo standard giapponese. E quindi: 1,58 di altezza, 43 chili di peso, bruna con i capelli a caschetto, un volto di fattezze umane realizzato studiando i parametri di bellezza delle donne giapponesi tra i 19 ed i 29 anni. La ‘pellè del corpo però è metallica, l’idea di darle un look da liceale è stata accantonata. «Il nostro programma - ha detto il direttore del progetto, Shuji Kajida - consisteva nel concepire un essere che avesse sembianze vicine a quelle umane e potesse interagire con l’uomo, ma abbiamo voluto evitare quella sensazione di disagio che sarebbe emersa se le avessimo dato fattezze troppo simili a quelle di una donna». In compenso, l’andatura di quella che è la quarta piattaforma robotica presentata dall’Aist è decisamente più elegante degli androidi suoi predecessori. «Abbiamo analizzato la camminata delle mannequin per programmare le diverse posture» ha spiegato Kujida. E la Campbell forse si preoccupa ancora di più. (Ansa AFP).

Hard Disk Molecolari - Come ospitare 5000 CD su un centimetro quadro

Ascolta l'intervista a Roberta Sessoli e Matteo Mannini

Sempre più piccolo: se un leitmotiv si può rintracciare nel convulso sviluppo delle tecnologie informatiche, è la progressiva miniaturizzazione di tutti i componenti e i dispositivi elettronici (basta pensare alla tecnologia racchiusa attualmente dai cellulari). Tuttavia, quella che può apparire esclusivamente una moda, è in realtà una sorta di via obbligata; quasi una condanna. Per aumentare la capacità di calcolo e di memorizzazione dei dati non c'è alternativa alla miniaturizzazione. Diversamente, i consumi elettrici e il calore prodotto dai componenti elettronici durante il funzionamento di un qualunque dispositivo, diverrebbero rapidamente insostenibili al crescere della complessità del circuito.

Le memorie magnetiche, che conservano l'informazione a tempo indeterminato, sono uno dei componenti chiave di tutta la filiera. Ecco perché, dal punto di vista tecnologico, si stanno compiendo sforzi enormi per aumentare la densità di scrittura, cioè per scrivere ogni singolo dato nella porzione più piccola possibile di materiale magnetico.

Un hard disk funziona in modo del tutto simile ad un sofisticato giradischi. Ogni volta che lanciamo il comando di scrittura o lettura di un file, il disco viene fatto ruotare rapidamente e un apposito braccio provvede a scrivere o a leggere l'informazione desiderata, magnetizzando piccole porzioni del sottile strato di materiale metallico che ricopre la superficie del disco. A parità di dimensioni del disco, la quantità di dati che in esso è possibile immagazzinare dipende dalla densità di scrittura: quanto più piccole sono le singole porzioni di superficie che conservano un comportamento magnetico, tanti più dati vi si possono memorizzare: un po' come la lunghezza del testo contenuto in una pagina dipende dalle dimensioni del carattere utilizzato.

Gli oggetti più piccoli nei quali sia possibile immagazzinare informazione magnetica sono speciali molecole scoperte all'inizio degli anni '90 da Dante Gatteschi e Roberta Sessoli dell'Università di Firenze. Si tratta di minuscoli aggregati di ioni metallici (per lo più manganese e ferro) con dimensioni dell'ordine del nano-metro, cioè del miliardesimo di metro (bisognerebbe metterne in fila un milione per raggiungere una lunghezza di 1 millimetro). In una collaborazione ormai ultradecennale con l'equipe del Prof. Andrea Cornia del Dipartimento di Chimica di Modena, i ricercatori di Firenze si sono specializzati nella preparazione di queste nano-molecole magnetiche, la cui struttura è spesso assai fragile. E negli ultimi due anni sono riusciti a sviluppare nuove nano-molecole con struttura estremamente stabile. Infine, grazie al contributo di colleghi dell'Université Pierre et Marie Curie di Parigi, hanno finalmente dimostrato che una superficie d'oro ricoperta da un singolo strato di nano-molecole, formate da quattro ioni ferro e agganciate alla superficie con un cavo organico, mostra un effetto memoria. Ci sono quindi tutti gli ingredienti di base necessari per realizzare memorie di massa stabili ad altissima densità: qualcosa come 5000 CD su una superficie di un centimetro quadrato, migliaia di volte la densità di scrittura raggiunta attualmente. Inoltre, queste molecole potrebbero esibire proprietà utili anche nel campo, di più lontana applicazione, della spintronica e dei calcolatori quantistici. Il lavoro, che ha visto come principale autore Matteo Mannini dell'Università di Firenze, è stato recensito da riviste prestigiose quali Nature Nanotecnology e Materials Today".

Siamo decisamente nello stadio della ricerca di base - precisano sia Sessoli che Mannini: le molecole utilizzate sono stabili soltanto a temperature molto basse e l'informazione persiste per tempi assai brevi. Ma l'industria elettronica ci ha abituato a sviluppi molto rapidi. Tra 5 o 6 anni, queste stesse sperimentazioni potrebbero benissimo configurarsi come ricerca applicata. Siamo cioè nella fase in cui si è prodotta una buona idea, dotata di grandi potenzialità, ma che necessita di essere coltivata per esprimere il proprio potenziale, e restituire moltiplicati alla collettività anche gli investimenti fatti fin qui. E' questa una fase in cui l'Italia fatica molto a non perdere il pallino, e vede spesso le proprie idee, assieme a chi le ha concepite, emigrare verso altri lidi. E' questo uno dei punti in cui il Paese deve migliorare più rapidamente, se vuole guadagnare competitività.

Fibre ottiche superveloci

Riferimento: Nature Photonics ADVANCE ONLINE PUBLICATION DOI:10.1038/nphoton.2009.25

sabato 14 marzo 2009

Verso un'analisi 'topografica' del DNA

L'analisi della sua struttura tridimensionale indica come le regioni del genoma non codificanti ma funzionalmente attive siano il doppio di quelle finora considerate.

Un nuovo modo di rilevare le regioni funzionali del DNA, che coinvolge l'osservazione della struttura in 3D del DNA, e non soltanto la sequenza di basi. è stato messo a punto da un gruppo di ricercatori dei National Institutes of Health (NIH), del National Human Genome Research Institute (NHGRI), e dalla Boston University, che lo illustrano in un articolo pubblicato in anteprima online sul sito di "Science". Questo nuovo metodo "topografico" prevede l'identificazione di tutte i ripiegamenti, le anse, le concavità del genoma umano per confrontarle con le caratteristiche strutturali degli elementi corrispondenti rilevabili in altre specie. E' verosimile, osservano i ricercatori, che le caratteristiche strutturali conservate in molte specie abbiano un ruolo importante nelle funzioni dell'organismo, mentre quelle che sono cambiate potrebbero avere un significato minore. "Il nuovo approccio rappresenta un esaltante progresso che accelererà i nostri sforzi di identificazione degli elementi funzionali del genoma. che rappresenta una delle maggiori sfide della genomica di oggi", ha commentato Eric Green. Insieme alle continue innovazioni nel sequenziamento del DNA, questo approccio topografico allargherà i nostri orizzonti nel tentativo di usare le informazioni del genoma per la salute dell'uomo."Nello studio, i ricercatori hanno confrontato la topografia del genoma umano con quella di altre 36 specie di mammiferi, fra le quali il topo, il coniglio, l'elefante e lo scimpanzé. In questo modo hanno trovato che circa il 12 per cento del genoma umano non codificante sarebbe funzionalmente significativo, vale a dire una percentuale doppia rispetto a quella stimata ricorrendo a metodi che si limitano confrontare le sequenze di DNA.I ricercatori osservano infatti che non sempre la sequenza di basi del DNA rappresenta un buon indicatore di funzionalità. Hanno infatti scoperto che sequenze di DNA molto simili possono assumere forma topografiche estremamente differenti, un fatto che può avere un impatto significativo sulla loro possibilità di essere o meno funzionalmente attive. D'altra parte, sequenze differenti possono assumere conformazioni topografiche molto simili e svolgere funzioni analoghe. La conclusione dei ricercatori è che in molti casi la struttura tridimensionale del DNA può essere un fattore predittivo molto più preciso della funzionalità di una sequenza di DNA. (gg)

venerdì 13 marzo 2009

Quando il cervello si rigenera: Nuova scoperta sulle staminali

Un algoritmo per 'leggere' i ricordi

giovedì 12 marzo 2009

Scoperta una nuova struttura nanoscopica del ghiaccio.

FONTE

FONTETutti conoscono la classica forma del fiocco di neve: sei braccia che si allungano dal centro, descrivendo, con le loro estremità, un esagono regolare, ossia il motivo geometrico del reticolo cristallino più comune con cui si presenta l'acqua allo stato solido. Tuttavia, se la struttura cristallina del ghiaccio è ben nota a livello di macroscale, a livello microscopico la sua natura non è altrettanto chiara, soprattutto se si tratta di valutare gli arrangiamenti atomici assunti dall'acqua quando questa si trova a solidificare a contatto con un altro materiale.

“Per la prima volta abbiamo dimostrato che il ghiaccio si può organizzare in una estesa struttura a partire da pentagoni e non da esagoni”, afferma Angelos Michaelides del centro londinese: “una scoperta che ci aiuta anche a comprendere quale sia la natura dei legami idrogeno nell'acqua”. I ricercatori hanno infatti trovato che, alle dimensioni di circa 1 nanometro (un miliardesimo di metro), le prime catene di atomi che si formano - e che fungono da nucleo di aggregazione per le altre molecole - hanno una forma pentagonale e non esagonale.

La forma pentagonale sarebbe favorita rispetto alle altre perché facilita il legame tra l'acqua e le particelle di metallo presenti nell'atmosfera e, allo stesso tempo, assicura un forte legame idrogeno. La scoperta rivela anche una inaspettata adattabilità della struttura, dimostrando che la presenza di un substrato può essere sufficiente a indurre un arrangiamento non esagonale.

Un risvolto pratico di questa ricerca è legato alla possibilità di favorire la formazione di ghiaccio nelle nubi, ossia di innescare tutta quella serie di processi che conduce alla formazione della pioggia. La cristallizzazione di ghiaccio ad alta quota è infatti un passaggio fondamentale. Questa avviene prevalentemente all'interfaccia fra l'acqua liquida e altre particelle sospese nelle nubi (aerosol). Finora si è immaginato di potere accelerare la formazione delle nuvole immettendo in atmosfera molecole dalla struttura cristallina esagonale che facciano da centri di aggregazione. Ma questo studio suggerisce che possa essere più efficace puntare su strutture pentagonali. (l.c.)

Arriva la realtà virtuale che coinvolge i nostri cinque sensi

UN VIAGGIO A CINQUE SENSI – Sarà possibile collaudare le nuove tecnologie sviluppate dagli scienziati britannici delle Università di York e Warwick grazie all’utilizzo di un «bozzolo virtuale», in grado di trasmettere alla persona che si trova al suo interno tutte le sensazioni caratteristiche di un’esperienza reale. Per la prima volta nel campo della realtà virtuale, i cinque sensi vengono stimolati contemporaneamente da dispositivi specifici e in maniera coordinata. Al punto tale che, secondo quanto affermano i ricercatori, diventa impossibile capire se si sta vivendo un’esperienza reale o di finzione. Proprio per questa sua formidabile affinità con il mondo vero, la tecnologia è stata definita Real Virtuality (virtualità reale). Un modello dimostrativo del «bozzolo virtuale» è stato presentato il 4 marzo 2009, in esclusiva, al Pioneers 09 di Londra, evento organizzato dall'EPSRC (Engineering and Physical Sciences Research Council) e dedicato alle innovazioni scientifiche rilevanti per il mondo delle aziende.

IN OGNI LUOGO, IN OGNI TEMPO – Grazie alla Real Virtuality in futuro si potrà viaggiare in tutto il mondo senza allontanarsi dalla propria città. Il bozzolo virtuale potrà trasformarsi anche in macchina del tempo, ricostruendo gli ambienti, i rumori, i sapori e i profumi delle antiche civiltà e facendo vivere un salto indietro nella storia. Fino ad oggi non era stato inventato – e neppure progettato – un sistema che permettesse di compiere un vero e proprio viaggio sensoriale che coinvolgesse tutti e cinque i sensi contemporaneamente. «I progetti di realtà virtuale si sono focalizzati sempre su uno o due sensi (di solito la vista e l’udito). Non conosciamo nessun altro gruppo di ricerca nel mondo che sta progettando quello che noi stiamo per fare», afferma David Howard, professore presso l’Università di York, a capo del progetto. «L’odore sarà generato elettronicamente attraverso una nuova tecnica sperimentata da Alan Chalmers e gli scienziati dell’Università di Warwick: profumi predeterminati attraverso combinazioni specifiche verranno rilasciati a richiesta. Gusto e olfatto sono strettamente legati, ma abbiamo intenzione di fornire anche una sensazione concreta, come se si avesse qualcosa in bocca. Dispositivi tattili provvederanno al senso del tatto».

ETICA E TECNOLOGIA – Grazie alla continua evoluzione delle tecnologie elettroniche e informatiche i ricercatori inglesi puntano a rendere il «bozzolo interattivo» sempre più leggero, confortevole ed economico. Dopo la presentazione a Londra, quindi, potrebbe non essere lontano il lancio sul mercato, con applicazioni in diversi campi come l’educazione e la protezione ambientale; anche se il progetto ha già sollevato un dibattito pubblico riguardo alle implicazioni etiche e agli effetti che questa tecnologia potrebbe avere sulla salute, comportando l’immersione totale dell’utente in un ambiente virtuale che lo isola completamente dal mondo reale. «Oltre alle implementazioni dal punto di vista tecnologico - afferma Howard - uno dei nostri prossimi obiettivi è anche valutare attentamente tutte le implicazioni, economiche e di altro tipo, dell’impiego delle tecnologie di Virtualità Reale nella società».

Valentina Tubino, 04 marzo 2009

mercoledì 11 marzo 2009

I condensati di Fröhlich, possono avere interessanti applicazioni in campo biochimico.

FONTE

FONTEUn nuovo metodo per modulare l'espressione dei geni

martedì 10 marzo 2009

I bambini di padri over 45 "hanno più problemi cognitivi"

Lo studio è destinato a fare polemica; intanto è un'analisi retrospettiva sui dati raccolti negli Stati Uniti su oltre 33.500 bambini nati fra il 1959 e il 1965, in tre fasi successive: a otto mesi, quattro e sette anni. John McGrath, a capo del team della Università di Brisbane che ha condotto la ricerca, ha deciso di avvalersi di questa messe di dati di fronte alla crescente tendenza a fare figli in età più avanzata, sia per gli uomini che per le donne.

I bambini erano stati valutati per coordinazione fra mano e occhio, discriminazione sensoriale e conoscenza astratta; i più grandi anche per capacità di lettura, scrittura e nozioni aritmetiche. Secondo McGrath, le capacità neurocognitive dei piccoli decrescevano in maniera sensibile con l'aumentare dell'età del padre. "Il trend di questi dati è relativamente coerente per fasce d'età e funzioni neurocognitive" ha detto McGrath. "Alla luce dell'aumento delle paternità ritardate, le implicazioni cliniche richiedono un esame più accurato". In altre parole: fate figli da giovani.

Lo studio comunque non è in grado di dire se quei bambini degli anni Sessanta più in là recuperarono lo svantaggio coi coetanei. L'età più avanzata del padre potrebbe essere collegata a una serie di problemi congeniti neurologici ma anche all'insorgere di malattie come schizofrenia, dislessia, disordine bipolare, autismo.

Fino ad oggi, molti studi sono stati effettuati sul rischio delle gravidanze in età materna avanzata, e quasi nessuno sui rischi delle paternità ritardate; gli uomini producono cellule spermatiche nuove tutta la vita, caratteristica che si pensava proteggesse la qualità del seme.